Kompleksowy monitoring infrastruktury IT

Katgoria: IT Solutions / Utworzono: 02 wrzesień 2011

Kompleksowy monitoring infrastruktury IT

Narzędzia ITSM ManageEngine firmy ZOHO Corp

Niniejszy artykuł chciałbym poświęcić na omówienie zagadnień związanych z monitoringiem infrastruktury informatycznej w sposób kompleksowy, o maksymalnym zakresie, w odniesieniu do usług świadczonych przez dział IT dla biznesu. Czyli monitoring w aspekcie biznesowym – zorientowanie na usługi.

Spróbujmy zastanowić się przez chwilę nad zagadnieniem zarządzania infrastrukturą informatyczną jakim jest monitoring. Czym właściwie jest monitoring, a czym zarządzanie. Monitoring umożliwia przede wszystkim mierzenie, pozyskiwanie informacji, analizę, wyciąganie wniosków w oparciu o gromadzone dane. Zarządzanie ma szerszy aspekt. Posiadając mechanizmy zarządzania możemy planować, rozwijać, projektować…

Monitoring jest podstawowym elementem zarządzania infrastrukturą informatyczną. Dzięki narzędziom monitorującym, możemy zarządzać zdarzeniami w ramach naszych zasobów oraz zarządzać wydajnością. To z kolei umożliwia nam dostęp do funkcji definiowania i szacowania mierników oceniających infrastrukturę. Na tej podstawie możemy rozwijać nasze zasoby, oraz usługi – ale to już jest temat dla zarządzania IT.

Przyjrzyjmy się przez chwilę bibliotekom ITIL® (metodologia zarządzania infrastrukturą informatyczną). To w zasadzie najpopularniejszy, najbardziej elastyczny i kompleksowy zestaw dobrych praktyk w IT, stosowany z sukcesami również w Polsce.

Monitoring jest kluczowym komponentem cyklu życia ITIL®. Bez niego nie ma możliwości oceny wydajności organizacji IT. Definicja monitoringu wg ITIL® mówi o „działaniach związanych z obserwacją sytuacji w celu wykrycia zmian w czasie”. Takie podejście wymusza stałą obserwację, przechwytywanie danych o wydajności i incydentach, jak również dostarczanie analiz na potrzeby procesów decyzyjnych.

Zgodnie z ITIL® monitoring jest wpisany w kilka procesów związanych z cyklem życia usługi: zarządzanie incydentami, zarządzanie problemami, zarządzanie zmianą, zarządzanie pojemnością, a w zasadzie elementy monitoringu bądź informacje jakie dostarcza są wykorzystywane we wszystkich procesach z Continual Service Improvement włącznie.

Jak realizować te postulaty ITSM. W ramach zakresu powinniśmy stosować narzędzia automatyzujące proces monitoringu i rejestracji zdarzeń (czyli nie ping od czasu do czasu uruchamiany ręcznie przez administratora na wybiórcze maszyny), ale również automatyzujące działania w ramach monitoringu, czyli analitykę i powiadamianie. Powinniśmy również starać się ograniczać ilość powiadomień generowanych przez urządzenia ze sobą powiązane (router – switch – serwer), nawet jeżeli nie znajdują się w jednej warstwie. Przede wszystkim powinniśmy jednak możliwie maksymalnie i w sposób uzasadniony ekonomicznie i biznesowo rozszerzyć obszar monitorowania infrastruktury.

Przyjrzyjmy się przez chwilę bibliotekom ITIL® (metodologia zarządzania infrastrukturą informatyczną). To w zasadzie najpopularniejszy, najbardziej elastyczny i kompleksowy zestaw dobrych praktyk w IT, stosowany z sukcesami również w Polsce.

Monitoring jest kluczowym komponentem cyklu życia ITIL®. Bez niego nie ma możliwości oceny wydajności organizacji IT. Definicja monitoringu wg ITIL® mówi o „działaniach związanych z obserwacją sytuacji w celu wykrycia zmian w czasie”. Takie podejście wymusza stałą obserwację, przechwytywanie danych o wydajności i incydentach, jak również dostarczanie analiz na potrzeby procesów decyzyjnych.

Zgodnie z ITIL® monitoring jest wpisany w kilka procesów związanych z cyklem życia usługi: zarządzanie incydentami, zarządzanie problemami, zarządzanie zmianą, zarządzanie pojemnością, a w zasadzie elementy monitoringu bądź informacje jakie dostarcza są wykorzystywane we wszystkich procesach z Continual Service Improvement włącznie.

Jak realizować te postulaty ITSM. W ramach zakresu powinniśmy stosować narzędzia automatyzujące proces monitoringu i rejestracji zdarzeń (czyli nie ping od czasu do czasu uruchamiany ręcznie przez administratora na wybiórcze maszyny), ale również automatyzujące działania w ramach monitoringu, czyli analitykę i powiadamianie. Powinniśmy również starać się ograniczać ilość powiadomień generowanych przez urządzenia ze sobą powiązane (router – switch – serwer), nawet jeżeli nie znajdują się w jednej warstwie. Przede wszystkim powinniśmy jednak możliwie maksymalnie i w sposób uzasadniony ekonomicznie i biznesowo rozszerzyć obszar monitorowania infrastruktury.

Kiedy spojrzymy na naszą infrastrukturę IT w aspekcie świadczonych przez departament IT usług dla biznesu, zauważymy, że proces świadczenia tej usługi opiera się na takich trzech kluczowych obszarach/warstwach. Warstwa najbliższa użytkownikowi, czyli aplikacje (ERP, CRM, BI, usługi mailowe). Aplikacje te pracują na serwerach/stacjach roboczych, połączonych ze sobą i tworzących sieć w oparciu o strukturę switchy i routerów (ogólnie urządzeń dostępowych). Sam proces komunikacji przebiega w oparciu o ruch na poszczególnych interfejsach. Monitoring tych trzech warstw jest kluczowy z punktu widzenia dostępności świadczonych usług IT dla biznesu.

Produkty ManageEngine (www.manageengine.pl) firmy ZOHO Corp, której wyłącznym dystrybutorem na Polskę jest firma MWT Solutions Sp. z o.o. (www.mwtsolutions.pl), dostarczają nam właśnie zestaw narzędzi, optymalizujący zakres monitorowania naszej infrastruktury informatycznej. Produkty Applications Manager (http://mwtsolutions.pl/content/view/87/39/lang,pl/), OpManager (http://mwtsolutions.pl/content/view/6/31/lang,pl/) i NetFlow Analyzer (http://mwtsolutions.pl/content/view/539/322/lang,pl/), tworzą wspólnie zintegrowane, wygodne w pracy i intuicyjne środowisko monitoringu IT.

Produkty ManageEngine (www.manageengine.pl) firmy ZOHO Corp, której wyłącznym dystrybutorem na Polskę jest firma MWT Solutions Sp. z o.o. (www.mwtsolutions.pl), dostarczają nam właśnie zestaw narzędzi, optymalizujący zakres monitorowania naszej infrastruktury informatycznej. Produkty Applications Manager (http://mwtsolutions.pl/content/view/87/39/lang,pl/), OpManager (http://mwtsolutions.pl/content/view/6/31/lang,pl/) i NetFlow Analyzer (http://mwtsolutions.pl/content/view/539/322/lang,pl/), tworzą wspólnie zintegrowane, wygodne w pracy i intuicyjne środowisko monitoringu IT.

Systemy te doskonale wpasowują się w trzywarstwowy model usług IT w biznesie. Applications Manager odpowiada za monitorowanie końcówek usług – aplikacji i komponentów IT biorących udział w realizacji usługi. OpManager stale bada dostępność i wydajność urządzeń sieciowych, takich jak switche, routery, serwery. Z kolei NetFlow Analyzer monitoruje przepustowość łączy i analizuje zużycie pasma pod kątem krytycznych aplikacji biznesowych.

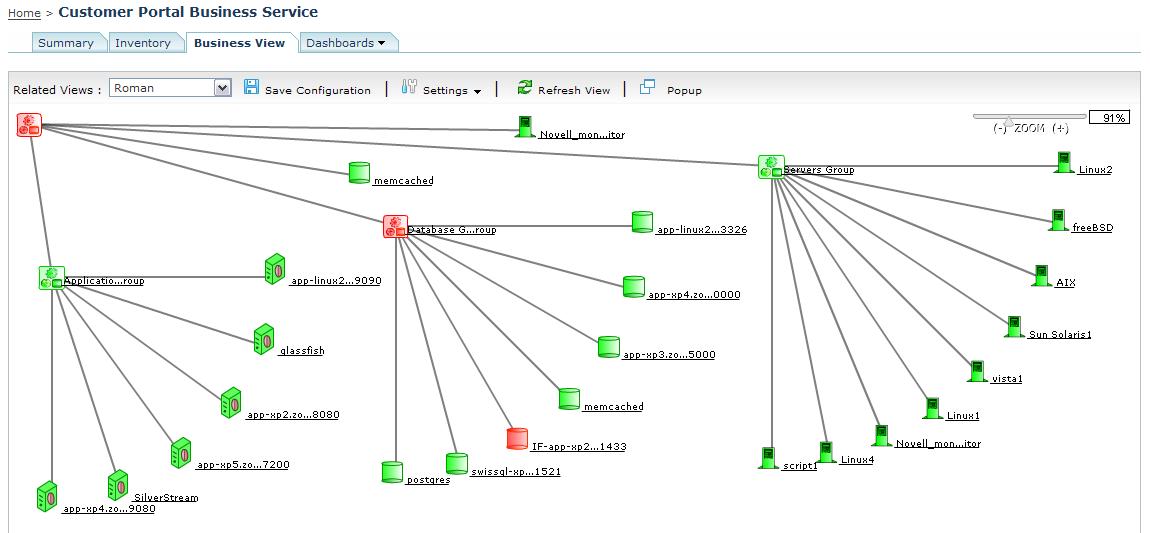

Applications Manager zapewnia administratorom ujednolicony, całościowy wgląd w infrastrukturę IT organizacji. Co możemy monitorować? Przede wszystkim aplikacje biznesowe, wykorzystywane w ramach dostarczania usług IT: systemy ERP, serwery bazodanowe, serwery aplikacji, portale internetowe, usługi typu SaaS (Software as a Service). Na podstawie danych zebranych w ten sposób, możemy również dokonywać badań anomalii.

Applications Manager zapewnia administratorom ujednolicony, całościowy wgląd w infrastrukturę IT organizacji. Co możemy monitorować? Przede wszystkim aplikacje biznesowe, wykorzystywane w ramach dostarczania usług IT: systemy ERP, serwery bazodanowe, serwery aplikacji, portale internetowe, usługi typu SaaS (Software as a Service). Na podstawie danych zebranych w ten sposób, możemy również dokonywać badań anomalii.

Jakie informacje otrzymujemy? Przede wszystkim dane dotyczące dostępności, oraz zdrowia nie tylko poszczególnych komponentów IT, ale przede wszystkim całych usług, dostarczenie których zależy od tych komponentów.

Dzięki systemowi OpManager dostajemy wgląd w prace naszej sieci z perspektywy administratora sieciowego. Możemy monitorować różne parametry serwerów, stacji roboczych, usług postawionych na urządzeniach, baz danych. Otrzymujemy profesjonalne narzędzie monitoringu z rozbudowanym systemem generowania alertów oraz powiadomień. Dzięki temu nasze podejście do zagrożeń staje się bardziej pro aktywne. Poprzez integrację komponenty sieciowe wykryte przez OpManager są widoczne również w Applications Manager.

Dzięki systemowi OpManager dostajemy wgląd w prace naszej sieci z perspektywy administratora sieciowego. Możemy monitorować różne parametry serwerów, stacji roboczych, usług postawionych na urządzeniach, baz danych. Otrzymujemy profesjonalne narzędzie monitoringu z rozbudowanym systemem generowania alertów oraz powiadomień. Dzięki temu nasze podejście do zagrożeń staje się bardziej pro aktywne. Poprzez integrację komponenty sieciowe wykryte przez OpManager są widoczne również w Applications Manager.

Co daje nam OpManager? Monitorowanie obciążenia procesora, monitorowanie pamięci operacyjnej oraz wykorzystania miejsca na dyskach, analizę i identyfikację urządzeń o wysokim obciążeniu procesora, pamięci lub dysków, egzotyczne funkcje, jak monitorowanie statusu urządzeń typu UPS (aspekty zarządzania dostępnością na niskiej warstwie), monitorowanie czasu zasilania awaryjnego oraz stanu akumulatorów, powiadomienia o zacięciu papieru lub jego braku w drukarkach, monitorowanie poziomu tuszy i tonerów. W zasadzie możemy uzyskać dowolną informację występującą w obiektach MIB.

Z kolei NetFlow Analyzer jest rozwiązaniem wykorzystywanym w celu optymalizacji działania sieci tak, aby zapewnić jej najwyższą wydajność. Jest to narzędzie, które umożliwia dokładny wgląd w to, co dzieje się w sieci – aplikacja pozwala nam uzyskać wiedzę w czasie rzeczywistym na temat tego jak ruch w sieci wpływa na funkcjonowanie aplikacji biznesowych. System opiera się na protokole NetFlow i gromadzi dane z routerów i przełączników, a następnie prezentuje te dane w postaci analizy ruchu sieci oraz monitoruje ilość danych przesłanych i odebranych w danym czasie.

Z kolei NetFlow Analyzer jest rozwiązaniem wykorzystywanym w celu optymalizacji działania sieci tak, aby zapewnić jej najwyższą wydajność. Jest to narzędzie, które umożliwia dokładny wgląd w to, co dzieje się w sieci – aplikacja pozwala nam uzyskać wiedzę w czasie rzeczywistym na temat tego jak ruch w sieci wpływa na funkcjonowanie aplikacji biznesowych. System opiera się na protokole NetFlow i gromadzi dane z routerów i przełączników, a następnie prezentuje te dane w postaci analizy ruchu sieci oraz monitoruje ilość danych przesłanych i odebranych w danym czasie.

Co daje nam NetFlow? Przede wszystkim informacje o zużyciu łącza przez określone aplikacje. Udział w ruchu sieciowym z rozbiciem na poszczególne aplikacje, pozwala uzyskać natychmiastowy wgląd w dane na temat aplikacji generujących największy ruch. Dane takie można prześledzić w celu zlokalizowania głównych źródeł oraz kierunków przepływu danych dla poszczególnych aplikacji. Dzięki takim szczegółowym danym, lokalizowanie i rozwiązywanie problemów, np. ograniczonej dostępności usług biznesowych (np. voip), zajmuje znacznie mniej czasu niż ma to miejsce przy użyciu tradycyjnych narzędzi.

Te trzy narzędzia doskonale się uzupełniają i integrują ze sobą. Właśnie możliwość integracji znacznie rozbudowuje funkcjonalność kompleksowego monitorowania usług. Jeżeli założymy, że grupa w systemie Applications Manager reprezentuje komponenty niezbędne do dostarczenia usługi, to przed integracją mieliśmy możliwość monitorowania aplikacji i systemów. Po integracji z systemem OpManager dochodzi nam możliwość dokładniejszego monitoringu fizycznych serwerów oraz routerów czy switchy, które mogą być również uwzględniane w logice generowania alarmów. Zatem wraz z monitoringiem zaczynamy schodzić o warstwę niżej. Jeżeli dodatkowo zintegrujemy system OpManager z systemem NetFlow Analyzer, to uzupełnimy monitoring usług o wysycenie pasma pod kątem krytycznych aplikacji biznesowych. Oprócz podstawowych statystyk dla interfejsu, uzyskamy wgląd w dane dotyczące przepływu z podziałem na poszczególne protokoły/aplikacje ustawione w NetFlow Analyzer. Możemy je dalej analizować wybierając dowolny atrybut. Zostaniemy przeniesieni już do samej aplikacji NetFlow Analyzer, która daje nam możliwości dogłębnej analizy potoku danych. W ten sposób, integrując Applications Manager z OpManager i dalej OpManager z NetFlow Analyzer uzyskaliśmy kompleksowy przegląd całej naszej infrastruktury pod kątem usług IT.

Trzeba pamiętać, że nie ma jednej skutecznej metodyki pracy na zintegrowanych systemach. Warto jednak wychodzić od Applications Manager, zwłaszcza gdy zależy nam na monitorowaniu dostępności usług. Wtedy, najlepszym rozwiązaniem jest wsparcie systemu informacjami dostarczanymi przez OpManager oraz NetFlow Analyzer. Taktyka oraz sposoby monitorowania zależą oczywiście od administratorów oraz osób odpowiedzialnych za usługę, jednak każdy powinien zastanowić się nad rozwiązaniem zwiększającym możliwości oraz wydajność pracy urządzeń, które odgrywają nadrzędną rolę we współczesnym biznesie.

Applications Manager zapewnia administratorom ujednolicony, całościowy wgląd w infrastrukturę IT organizacji. Co możemy monitorować? Przede wszystkim aplikacje biznesowe, wykorzystywane w ramach dostarczania usług IT: systemy ERP, serwery bazodanowe, serwery aplikacji, portale internetowe, usługi typu SaaS (Software as a Service). Na podstawie danych zebranych w ten sposób, możemy również dokonywać badań anomalii.

Applications Manager zapewnia administratorom ujednolicony, całościowy wgląd w infrastrukturę IT organizacji. Co możemy monitorować? Przede wszystkim aplikacje biznesowe, wykorzystywane w ramach dostarczania usług IT: systemy ERP, serwery bazodanowe, serwery aplikacji, portale internetowe, usługi typu SaaS (Software as a Service). Na podstawie danych zebranych w ten sposób, możemy również dokonywać badań anomalii. Dzięki systemowi OpManager dostajemy wgląd w prace naszej sieci z perspektywy administratora sieciowego. Możemy monitorować różne parametry serwerów, stacji roboczych, usług postawionych na urządzeniach, baz danych. Otrzymujemy profesjonalne narzędzie monitoringu z rozbudowanym systemem generowania alertów oraz powiadomień. Dzięki temu nasze podejście do zagrożeń staje się bardziej pro aktywne. Poprzez integrację komponenty sieciowe wykryte przez OpManager są widoczne również w Applications Manager.

Dzięki systemowi OpManager dostajemy wgląd w prace naszej sieci z perspektywy administratora sieciowego. Możemy monitorować różne parametry serwerów, stacji roboczych, usług postawionych na urządzeniach, baz danych. Otrzymujemy profesjonalne narzędzie monitoringu z rozbudowanym systemem generowania alertów oraz powiadomień. Dzięki temu nasze podejście do zagrożeń staje się bardziej pro aktywne. Poprzez integrację komponenty sieciowe wykryte przez OpManager są widoczne również w Applications Manager. Z kolei NetFlow Analyzer jest rozwiązaniem wykorzystywanym w celu optymalizacji działania sieci tak, aby zapewnić jej najwyższą wydajność. Jest to narzędzie, które umożliwia dokładny wgląd w to, co dzieje się w sieci – aplikacja pozwala nam uzyskać wiedzę w czasie rzeczywistym na temat tego jak ruch w sieci wpływa na funkcjonowanie aplikacji biznesowych. System opiera się na protokole NetFlow i gromadzi dane z routerów i przełączników, a następnie prezentuje te dane w postaci analizy ruchu sieci oraz monitoruje ilość danych przesłanych i odebranych w danym czasie.

Z kolei NetFlow Analyzer jest rozwiązaniem wykorzystywanym w celu optymalizacji działania sieci tak, aby zapewnić jej najwyższą wydajność. Jest to narzędzie, które umożliwia dokładny wgląd w to, co dzieje się w sieci – aplikacja pozwala nam uzyskać wiedzę w czasie rzeczywistym na temat tego jak ruch w sieci wpływa na funkcjonowanie aplikacji biznesowych. System opiera się na protokole NetFlow i gromadzi dane z routerów i przełączników, a następnie prezentuje te dane w postaci analizy ruchu sieci oraz monitoruje ilość danych przesłanych i odebranych w danym czasie.

Łukasz Harasimowicz, Product Manager, MWT Solutions Sp. z o.o. Absolwent wydziału Informatyki i Gospodarki Elektronicznej na Uniwersytecie Ekonomicznym w Poznaniu. Od ponad 5 lat związany z branżą IT, a w szczególności z systemami zarządzania infrastrukturą teleinformatyczną.

Łukasz Harasimowicz, Product Manager, MWT Solutions Sp. z o.o. Absolwent wydziału Informatyki i Gospodarki Elektronicznej na Uniwersytecie Ekonomicznym w Poznaniu. Od ponad 5 lat związany z branżą IT, a w szczególności z systemami zarządzania infrastrukturą teleinformatyczną.

Najnowsze wiadomości

Kwantowy przełom w cyberochronie - nadchodząca dekada przepisze zasady szyfrowania na nowo

Przez długi czas cyfrowe bezpieczeństwo opierało się na prostym założeniu: współczesne komputery potrzebowałyby ogromnych zasobów i wielu lat, aby złamać silne algorytmy szyfrowania. Rozwój technologii kwantowej zaczyna jednak tę regułę podważać, a eksperci przewidują, że w perspektywie 5–10 lat może nadejść „dzień zero”. Jest to moment, w którym zaawansowana maszyna kwantowa będzie w stanie przełamać większość aktualnie stosowanych zabezpieczeń kryptograficznych w czasie liczonym nie w latach, lecz w godzinach.

PSI prezentuje nową identyfikację wizualną

W ramach realizowanej strategii transformacji PSI Software SE zaprezentowała nową identyfikację wizualną. Odświeżony wizerunek w spójny sposób oddaje technologiczne zaawansowanie firmy, jej głęboką wiedzę branżową oraz silne ukierunkowanie na potrzeby klientów. Zmiany te wzmacniają pozycję PSI jako innowacyjnego lidera technologicznego w obszarze skalowalnych rozwiązań informatycznych opartych na sztucznej inteligencji i chmurze, rozwijanych z myślą o energetyce i przemyśle.

W ramach realizowanej strategii transformacji PSI Software SE zaprezentowała nową identyfikację wizualną. Odświeżony wizerunek w spójny sposób oddaje technologiczne zaawansowanie firmy, jej głęboką wiedzę branżową oraz silne ukierunkowanie na potrzeby klientów. Zmiany te wzmacniają pozycję PSI jako innowacyjnego lidera technologicznego w obszarze skalowalnych rozwiązań informatycznych opartych na sztucznej inteligencji i chmurze, rozwijanych z myślą o energetyce i przemyśle.

W ramach realizowanej strategii transformacji PSI Software SE zaprezentowała nową identyfikację wizualną. Odświeżony wizerunek w spójny sposób oddaje technologiczne zaawansowanie firmy, jej głęboką wiedzę branżową oraz silne ukierunkowanie na potrzeby klientów. Zmiany te wzmacniają pozycję PSI jako innowacyjnego lidera technologicznego w obszarze skalowalnych rozwiązań informatycznych opartych na sztucznej inteligencji i chmurze, rozwijanych z myślą o energetyce i przemyśle.

W ramach realizowanej strategii transformacji PSI Software SE zaprezentowała nową identyfikację wizualną. Odświeżony wizerunek w spójny sposób oddaje technologiczne zaawansowanie firmy, jej głęboką wiedzę branżową oraz silne ukierunkowanie na potrzeby klientów. Zmiany te wzmacniają pozycję PSI jako innowacyjnego lidera technologicznego w obszarze skalowalnych rozwiązań informatycznych opartych na sztucznej inteligencji i chmurze, rozwijanych z myślą o energetyce i przemyśle.

PROMAG S.A. rozpoczyna wdrożenie systemu ERP IFS Cloud we współpracy z L-Systems

PROMAG S.A., lider w obszarze intralogistyki, rozpoczął wdrożenie systemu ERP IFS Cloud, który ma wesprzeć dalszy rozwój firmy oraz integrację kluczowych procesów biznesowych. Projekt realizowany jest we współpracy z firmą L-Systems i obejmuje m.in. obszary finansów, produkcji, logistyki, projektów oraz serwisu, odpowiadając na rosnącą skalę i złożoność realizowanych przedsięwzięć.

F5 rozszerza portfolio bezpieczeństwa o narzędzia do ochrony systemów AI w środowiskach enterprise

F5 ogłosiło wprowadzenie dwóch nowych rozwiązań - F5 AI Guardrails oraz F5 AI Red Team - które mają odpowiedzieć na jedno z kluczowych wyzwań współczesnych organizacji: bezpieczne wdrażanie i eksploatację systemów sztucznej inteligencji na dużą skalę. Nowa oferta łączy ochronę działania modeli AI w czasie rzeczywistym z ofensy

Snowflake + OpenAI: AI bliżej biznesu

Snowflake przyspiesza wykorzystanie danych i sztucznej inteligencji w firmach, przenosząc AI z fazy eksperymentów do codziennych procesów biznesowych. Nowe rozwiązania w ramach AI Data Cloud integrują modele AI bezpośrednio z danymi, narzędziami deweloperskimi i warstwą semantyczną. Partnerstwo z OpenAI, agent Cortex Code, Semantic View Autopilot oraz rozwój Snowflake Postgres pokazują, jak budować skalowalne, bezpieczne i mierzalne wdrożenia AI w skali całej organizacji.

Najnowsze artykuły

Magazyn bez błędów? Sprawdź, jak system WMS zmienia codzienność logistyki

Współczesna logistyka wymaga nie tylko szybkości działania, lecz także maksymalnej precyzji – to właśnie te czynniki coraz częściej decydują o przewadze konkurencyjnej firm. Nawet drobne pomyłki w ewidencji stanów magazynowych, błędy przy przyjmowaniu dostaw czy nieprawidłowe rozmieszczenie towarów, mogą skutkować poważnymi stratami finansowymi i opóźnieniami w realizacji zamówień. W jaki sposób nowoczesne rozwiązania do zarządzania pomagają unikać takich sytuacji? Czym właściwie różni się tradycyjny system magazynowy od zaawansowanych rozwiązań klasy WMS (ang. Warehouse Management System)? I w jaki sposób inteligentne zarządzanie procesami magazynowymi realnie usprawnia codzienną pracę setek firm?

Współczesna logistyka wymaga nie tylko szybkości działania, lecz także maksymalnej precyzji – to właśnie te czynniki coraz częściej decydują o przewadze konkurencyjnej firm. Nawet drobne pomyłki w ewidencji stanów magazynowych, błędy przy przyjmowaniu dostaw czy nieprawidłowe rozmieszczenie towarów, mogą skutkować poważnymi stratami finansowymi i opóźnieniami w realizacji zamówień. W jaki sposób nowoczesne rozwiązania do zarządzania pomagają unikać takich sytuacji? Czym właściwie różni się tradycyjny system magazynowy od zaawansowanych rozwiązań klasy WMS (ang. Warehouse Management System)? I w jaki sposób inteligentne zarządzanie procesami magazynowymi realnie usprawnia codzienną pracę setek firm?

Migracja z SAP ECC na S4 HANA: Ryzyka, korzyści i alternatywne rozwiązania

W ostatnich latach wiele firm, które korzystają z systemu SAP ECC (Enterprise Central Component), stoi przed decyzją o przejściu na nowszą wersję — SAP S4 HANA. W obliczu końca wsparcia dla ECC w 2030 roku, temat ten staje się coraz bardziej aktualny. Przemiany technologiczne oraz rosnące oczekiwania związane z integracją nowych funkcji, jak sztuczna inteligencja (AI), skłaniają do refleksji nad tym, czy warto podjąć tak dużą zmianę w architekturze systemu. Przyjrzyjmy się głównym powodom, dla których firmy rozważają migrację do S4 HANA, ale także argumentom, które mogą przemawiać za pozostaniem przy dotychczasowym systemie ECC, przynajmniej na krótki okres.

Jak maksymalizować zyski z MTO i MTS dzięki BPSC ERP?

Zysk przedsiębiorstwa produkcyjnego zależy nie tylko od wydajności maszyn, ale przede wszystkim od precyzyjnego planowania, realnych danych i umiejętnego zarządzania procesami. Dlatego firmy, które chcą skutecznie działać zarówno w modelu Make to Stock (MTS), jak i Make to Order (MTO), coraz częściej sięgają po rozwiązania klasy ERP, takie jak BPSC ERP.

Zysk przedsiębiorstwa produkcyjnego zależy nie tylko od wydajności maszyn, ale przede wszystkim od precyzyjnego planowania, realnych danych i umiejętnego zarządzania procesami. Dlatego firmy, które chcą skutecznie działać zarówno w modelu Make to Stock (MTS), jak i Make to Order (MTO), coraz częściej sięgają po rozwiązania klasy ERP, takie jak BPSC ERP.

Ponad połowa cyberataków zaczyna się od błędu człowieka

Ponad 2/3 firm w Polsce odnotowała w zeszłym roku co najmniej 1 incydent naruszenia bezpieczeństwa . Według danych Unit 42, zespołu analitycznego Palo Alto Networks, aż 60% ataków rozpoczyna się od działań wymierzonych w pracowników – najczęściej pod postacią phishingu i innych form inżynierii społecznej . To pokazuje, że w systemie ochrony organizacji pracownicy są kluczowym ogniwem – i że firmy muszą nie tylko edukować, ale też konsekwentnie egzekwować zasady cyberhigieny. Warto o tym pamiętać szczególnie teraz, w październiku, gdy obchodzimy Europejski Miesiąc Cyberbezpieczeństwa.

MES - holistyczne zarządzanie produkcją

Nowoczesna produkcja wymaga precyzji, szybkości i pełnej kontroli nad przebiegiem procesów. Rosnąca złożoność zleceń oraz presja kosztowa sprawiają, że ręczne raportowanie i intuicyjne zarządzanie coraz częściej okazują się niewystarczające. Firmy szukają rozwiązań, które umożliwiają im widzenie produkcji „na żywo”, a nie z opóźnieniem kilku godzin czy dni. W tym kontekście kluczową rolę odgrywają narzędzia, które porządkują informacje i pozwalają reagować natychmiast, zamiast po fakcie.

Przeczytaj Również

Infrastruktura w punkcie zwrotnym - 5 prognoz kształtujących AI, odporność i suwerenność danych w 2026 roku

W 2026 roku zyskają firmy, które traktują infrastrukturę nie jako obszar generujący koszty, lecz ja… / Czytaj więcej

Tylko 7% firm w Europie wykorzystuje w pełni potencjał AI

72% firm w regionie EMEA uznaje rozwój narzędzi bazujących na sztucznej inteligencji za priorytet s… / Czytaj więcej

Chmura publiczna w Unii Europejskiej – między innowacją a odpowiedzialnością za dane

Transformacja cyfrowa w Europie coraz mocniej opiera się na chmurze publicznej, która stała się fun… / Czytaj więcej

Jak Cisco pomaga Europie spłacić dług technologiczny w krytycznej infrastrukturze sieciowej

Cyfryzacja, rozwój sztucznej inteligencji i nadchodzące komputery kwantowe wymagają od Europy stabi… / Czytaj więcej

MŚP inwestują w AI, kompetencje pracowników nadal wyzwaniem

Europejskie małe i średnie firmy coraz śmielej inwestują w sztuczną inteligencję, ale to kompetencj… / Czytaj więcej

AP EU AI Cloud: nowy standard suwerennej chmury i AI dla europejskich organizacji

SAP EU AI Cloud to zapowiedziana 27 listopada 2025 r. platforma, która łączy dotychczasowe inicjaty… / Czytaj więcej